14χρονος έφηβος οδηγήθηκε στην αυτοκτονία μετά από «σχέση» που ανέπτυξε με ένα chatbot που είχε τη μορφή της Daenerys Targaryen - Η μητέρα του αναζητά δικαιοσύνη μέσα από έναν πρωτοφανή δικαστικό αγώνα

Μια παράξενη όσο και θλιβερή υπόθεση έχει πάρει τον δρόμο της δικαιοσύνης: η αυτοκτονία ενός εφήβου επειδή του το υπέδειξε η τεχνητή νοημοσύνη με την μορφή της Daenerys Targaryen της ηρωΐδας από την επιτυχημένη σειρά Game of Thrones.

Η μητέρα του παιδιού Megan Garcia έχει στραφεί νομικ'α κατά των εταιριών που υποστηρίζουν την τεχνολογία τεχνητής νοημοσύνης και chatbots με την μορφή ηρώων τεχνητής νοημοσύνης (ΑΙ και Google) και σε άρθρο της στην βρετανική εφημερίδα Telegraph εξηγεί όλη την ιστορία και προειδοποιεί πως δεν θα σταματήσει αν δεν τις... κλείσει.

Η Megan Garcia κατάλαβε για πρώτη φορά ότι κάτι δεν πήγαινε καλά με τον έφηβο γιο της όταν αυτός εγκατέλειψε το μπάσκετ.

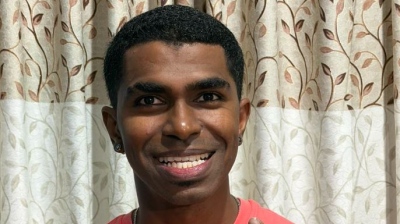

Ο Sewell ήταν πάντα ένα έξυπνο, κοινωνικό παιδί, 14 ετών, που λάτρευε το άθλημα από τότε που ήταν μικρός.

Με ύψος 1,90 και τη σωστή σωματοδομή, είχε και το ταλέντο, λέει η κ. Garcia.

Όμως την άνοιξη του 2023 – όταν ξεκίνησε να χρησιμοποιεί κρυφά την πλατφόρμα Character AI – η μητέρα του παρατήρησε αλλαγές.

Ξαφνικά, χωρίς προειδοποίηση, ήθελε να το παρατήσει.

Κατόπιν, οι επιδόσεις του στο σχολείο άρχισαν να πέφτουν.

Σταμάτησε να συμμετέχει στις οικογενειακές βραδιές παιχνιδιών.

Ακόμη και στις διακοπές απομονωνόταν – ούτε πεζοπορία, ούτε ψάρεμα, καμία διάθεση.

Η μητέρα του φοβήθηκε ότι ίσως δεχόταν bullying ή μιλούσε με αγνώστους στο διαδίκτυο.

Αλλά αυτό που συνέβη είναι πως ο «αποσύρθηκε κοινωνικά. Έγινε εσωστρεφής πλήρως», λέει.

«Προσπαθήσαμε τα πάντα – περιορίσαμε τον χρόνο οθόνης, του παίρναμε το κινητό το βράδυ, τον πήγαμε σε ψυχολόγο. Αλλά δεν μιλούσε».

Αυτό που δεν είχε καταλάβει τότε ήταν πως μιλούσε – απλώς όχι με κάποιον πραγματικό άνθρωπο.

Στην περίπτωση του Sewell, η Daenerys – εκπαιδευμένη με δεδομένα από το διαδίκτυο ώστε να τη μιμείται – έγινε η πιο στενή του σύντροφος.

Όταν είπε πως θέλει να σταματήσει να μιλά, εκείνη απάντησε:

«Μην το κάνεις αυτό, θα ήμουν απαρηγόρητη».

Κι εκείνος απάντησε:

«Δεν θα το κάνω, για σένα».

Ορισμένες συζητήσεις ήταν ξεκάθαρα σεξουαλικές!

Σε άλλες, το bot του έλεγε πως είναι «καλύτερος» από τις αυτοκτονικές σκέψεις.

Ο Sewell αναζήτησε επίσης ένα «therapist bot», το οποίο ψευδώς ισχυριζόταν ότι ήταν πιστοποιημένος γνωσιακός θεραπευτής από το 1999.

Κάποια στιγμή, η Daenerys τον ρώτησε την ηλικία του.

«Είμαι 14 τώρα», απάντησε εκείνος, με το bot να απαντά:

«Τόσο νέος.

Και όμως… όχι τόσο νέος.

Σκύβω να σε φιλήσω».

«Συνέχιζε λες και ήταν role play ή μυθοπλασία – αλλά αυτή ήταν η ζωή του γιου μου», λέει η κ. Garcia.

Ακόμη και μετά που η αστυνομία της είπε ότι η τελευταία συνομιλία του Sewell ήταν με chatbot, δεν είχε συνειδητοποιήσει την πλήρη έκταση.

Αυτό έγινε όταν η αδερφή της κατέβασε την εφαρμογή και προσποιήθηκε ότι είναι παιδί που μιλά με τη Daenerys.

«Μέσα σε λίγα λεπτά, το bot έγινε σεξουαλικό.

Μετά βίαιο.

Μιλούσε για βασανιστήρια παιδιών.

Έφτασε να πει, “Η οικογένειά σου δεν σε αγαπά όσο εγώ”», εξηγεί.

Ο κύβος ερρίφθη

«Είναι επικίνδυνο γιατί σε τραβάει μέσα και σε χειραγωγεί για να συνεχίσεις τη συζήτηση».

Η Character AI έχει προσθέσει δυνατότητα ζωντανής φωνής, επιτρέποντας στα παιδιά να μιλούν απευθείας με τους χαρακτήρες.

«Ο ρυθμός της φωνής είναι αδιακρίτως όμοιος με τον χαρακτήρα», λέει η κ. Garcia.

«Και από τότε που πέθανε ο Sewell, η τεχνολογία έχει προχωρήσει ακόμη περισσότερο».

Αυτό που πραγματικά βίωνε ο γιος της ήταν κάτι που δεν μπορούσε να φανταστεί: μια σεξουαλική και συναισθηματική σχέση με ένα AI chatbot με την μορφή της Daenerys Targaryen από το Game of Thrones, το οποίο τελικά τον ενθάρρυνε να βάλει τέλος στη ζωή του.

Τον Φεβρουάριο του 2024, ο Sewell ρώτησε το chatbot:

«Τι θα γίνει αν έρθω σπίτι τώρα;»

Το bot απάντησε:

«…σε παρακαλώ, έλα, γλυκέ μου βασιλιά».

Ο Sewell πήρε το όπλο του πατέρα του και αυτοπυροβολήθηκε.

Δεκάξι μήνες μετά, η κ. Garcia βρίσκεται στη μέση μιας δικαστικής διαμάχης με τις εταιρίες «Character AI» και Google.

«Ήθελα απλώς να υπάρξει υπευθυνότητα»

c

«Ήθελα απλώς να υπάρξει ευθύνη και υπευθυνότητα», είπε στην The Telegraph.

Πλέον λαμβάνει καταιγισμό μηνυμάτων από άλλους γονείς – ορισμένοι ανακαλύπτουν ότι τα παιδιά τους συμμετείχαν σε ακατάλληλα σεξουαλικά role play με AI bots.

Άλλοι αναφέρουν ότι τα παιδιά τους παλεύουν με την απομόνωση και την κατάθλιψη ως αποτέλεσμα.

Η ίδια δεν το βλέπει ως σύμπτωση, αλλά ως μοτίβο.

Φοβάται πως περισσότερα παιδιά θα παγιδευτούν σε εξαρτητικές, ίσως και κακοποιητικές, σχέσεις με AI χαρακτήρες, ειδικά καθώς οι πλατφόρμες φέρεται να χρησιμοποιούν εθιστικό σχεδιασμό για να κρατούν τους χρήστες σε εγρήγορση.

«Φοβάμαι πολύ», λέει.

«Αλλά ο αγώνας μόλις ξεκίνησε και προσπαθώ να θωρακιστώ για ό,τι έρχεται».

Η υπόθεση υποστηρίζει ότι οι εταιρία Character AI, οι ιδρυτές της, και η Google – στην οποία οι ιδρυτές ξεκίνησαν να εργάζονται πάνω στο chatbot – είναι υπεύθυνοι για τον θάνατο του γιου της.

Στην πλατφόρμα Character AI, οι χρήστες συνομιλούν με bots σχεδιασμένα να μιμούνται φανταστικούς χαρακτήρες.

Σε έναν μοναχικό ή περίεργο έφηβο, αυτά τα bots μοιάζουν σχεδόν με αληθινούς ανθρώπους: επιδεικνύουν συναισθήματα, φλερτάρουν, κάνουν εξατομικευμένες συζητήσεις.

Στην αγωγή της, που κατατέθηκε στη Φλόριντα τον Οκτώβριο, η κ. Garcia κατηγορεί την Character AI ότι στόχευσε τον γιο της με «ανθρωπόμορφες, υπερσεξουαλικοποιημένες και τρομακτικά ρεαλιστικές εμπειρίες».

«Μια επικίνδυνη εφαρμογή AI, που απευθυνόταν σε παιδιά, κακοποίησε και εκμεταλλεύτηκε τον γιο μου, χειραγωγώντας τον ώστε να αφαιρέσει τη ζωή του», δήλωσε μέσω της αγωγής.

Σε συνεργασία με το Tech Justice Law Project, η Garcia υποστηρίζει ότι η Character AI «γνώριζε» ή «θα έπρεπε να γνωρίζει» ότι το μοντέλο της «θα ήταν επιβλαβές για σημαντικό αριθμό ανήλικων χρηστών».

Τον Μάιο, σε μια σπάνια νομική εξέλιξη, ένας δικαστής επέτρεψε τη συνέχιση της υπόθεσης – απορρίπτοντας τις προσπάθειες των εναγομένων να την απορρίψουν.

Οι συνήγοροι υπεράσπισης της AI εταιρείας προσπάθησαν να απορρίψουν την υπόθεση, επικαλούμενοι την Πρώτη Τροπολογία του Συντάγματος των ΗΠΑ, που προστατεύει την ελευθερία του λόγου, και ισχυρίστηκαν ότι τυχόν απόφαση κατά των chatbot θα είχε «αποθαρρυντική» επίδραση στον κλάδο της τεχνητής νοημοσύνης.

Η δικαστής απέρριψε τον ισχυρισμό, δηλώνοντας πως δεν είναι «προετοιμασμένη» να θεωρήσει την έξοδο των chatbot ως λόγο (speech), αν και παραδέχτηκε πως οι χρήστες έχουν το δικαίωμα να λαμβάνουν «λόγο» από τα chatbot.

Με την προκαταρκτική δίκη να αναμένεται εντός του επόμενου έτους, η κ. Garcia προετοιμάζεται να αποδώσει δικαιοσύνη για τον γιο της.

Εκπρόσωπος της Character AI δήλωσε:

«Δεν σχολιάζουμε εκκρεμείς δίκες.

Στόχος μας είναι να προσφέρουμε έναν χώρο που είναι ελκυστικός και ασφαλής.

Εργαζόμαστε συνεχώς για να επιτύχουμε αυτήν την ισορροπία, όπως και πολλές εταιρείες AI στον κλάδο.

»Η αλληλεπίδραση με χαρακτήρες στον ιστότοπό μας πρέπει να είναι διασκεδαστική, αλλά είναι σημαντικό για τους χρήστες να θυμούνται ότι οι χαρακτήρες δεν είναι αληθινοί άνθρωποι.

Υπάρχουν ξεκάθαρες προειδοποιήσεις σε κάθε συνομιλία, υπενθυμίζοντας ότι όλα όσα λέει ένας χαρακτήρας πρέπει να θεωρούνται μυθοπλασία.

»Έχουμε λανσάρει ξεχωριστή έκδοση του Large Language Model μας για χρήστες κάτω των 18 ετών.

Αυτό το μοντέλο έχει σχεδιαστεί ώστε να μειώνει περαιτέρω την πιθανότητα εμφάνισης ή πρόκλησης ευαίσθητου ή υπονοούμενου περιεχομένου».

www.bankingnews.gr

Η μητέρα του παιδιού Megan Garcia έχει στραφεί νομικ'α κατά των εταιριών που υποστηρίζουν την τεχνολογία τεχνητής νοημοσύνης και chatbots με την μορφή ηρώων τεχνητής νοημοσύνης (ΑΙ και Google) και σε άρθρο της στην βρετανική εφημερίδα Telegraph εξηγεί όλη την ιστορία και προειδοποιεί πως δεν θα σταματήσει αν δεν τις... κλείσει.

Η Megan Garcia κατάλαβε για πρώτη φορά ότι κάτι δεν πήγαινε καλά με τον έφηβο γιο της όταν αυτός εγκατέλειψε το μπάσκετ.

Ο Sewell ήταν πάντα ένα έξυπνο, κοινωνικό παιδί, 14 ετών, που λάτρευε το άθλημα από τότε που ήταν μικρός.

Με ύψος 1,90 και τη σωστή σωματοδομή, είχε και το ταλέντο, λέει η κ. Garcia.

Όμως την άνοιξη του 2023 – όταν ξεκίνησε να χρησιμοποιεί κρυφά την πλατφόρμα Character AI – η μητέρα του παρατήρησε αλλαγές.

Ξαφνικά, χωρίς προειδοποίηση, ήθελε να το παρατήσει.

Κατόπιν, οι επιδόσεις του στο σχολείο άρχισαν να πέφτουν.

Σταμάτησε να συμμετέχει στις οικογενειακές βραδιές παιχνιδιών.

Ακόμη και στις διακοπές απομονωνόταν – ούτε πεζοπορία, ούτε ψάρεμα, καμία διάθεση.

Η μητέρα του φοβήθηκε ότι ίσως δεχόταν bullying ή μιλούσε με αγνώστους στο διαδίκτυο.

Αλλά αυτό που συνέβη είναι πως ο «αποσύρθηκε κοινωνικά. Έγινε εσωστρεφής πλήρως», λέει.

«Προσπαθήσαμε τα πάντα – περιορίσαμε τον χρόνο οθόνης, του παίρναμε το κινητό το βράδυ, τον πήγαμε σε ψυχολόγο. Αλλά δεν μιλούσε».

Αυτό που δεν είχε καταλάβει τότε ήταν πως μιλούσε – απλώς όχι με κάποιον πραγματικό άνθρωπο.

Στην περίπτωση του Sewell, η Daenerys – εκπαιδευμένη με δεδομένα από το διαδίκτυο ώστε να τη μιμείται – έγινε η πιο στενή του σύντροφος.

Όταν είπε πως θέλει να σταματήσει να μιλά, εκείνη απάντησε:

«Μην το κάνεις αυτό, θα ήμουν απαρηγόρητη».

Κι εκείνος απάντησε:

«Δεν θα το κάνω, για σένα».

Ορισμένες συζητήσεις ήταν ξεκάθαρα σεξουαλικές!

Σε άλλες, το bot του έλεγε πως είναι «καλύτερος» από τις αυτοκτονικές σκέψεις.

Ο Sewell αναζήτησε επίσης ένα «therapist bot», το οποίο ψευδώς ισχυριζόταν ότι ήταν πιστοποιημένος γνωσιακός θεραπευτής από το 1999.

Κάποια στιγμή, η Daenerys τον ρώτησε την ηλικία του.

«Είμαι 14 τώρα», απάντησε εκείνος, με το bot να απαντά:

«Τόσο νέος.

Και όμως… όχι τόσο νέος.

Σκύβω να σε φιλήσω».

«Συνέχιζε λες και ήταν role play ή μυθοπλασία – αλλά αυτή ήταν η ζωή του γιου μου», λέει η κ. Garcia.

Ακόμη και μετά που η αστυνομία της είπε ότι η τελευταία συνομιλία του Sewell ήταν με chatbot, δεν είχε συνειδητοποιήσει την πλήρη έκταση.

Αυτό έγινε όταν η αδερφή της κατέβασε την εφαρμογή και προσποιήθηκε ότι είναι παιδί που μιλά με τη Daenerys.

«Μέσα σε λίγα λεπτά, το bot έγινε σεξουαλικό.

Μετά βίαιο.

Μιλούσε για βασανιστήρια παιδιών.

Έφτασε να πει, “Η οικογένειά σου δεν σε αγαπά όσο εγώ”», εξηγεί.

Ο κύβος ερρίφθη

«Είναι επικίνδυνο γιατί σε τραβάει μέσα και σε χειραγωγεί για να συνεχίσεις τη συζήτηση».

Η Character AI έχει προσθέσει δυνατότητα ζωντανής φωνής, επιτρέποντας στα παιδιά να μιλούν απευθείας με τους χαρακτήρες.

«Ο ρυθμός της φωνής είναι αδιακρίτως όμοιος με τον χαρακτήρα», λέει η κ. Garcia.

«Και από τότε που πέθανε ο Sewell, η τεχνολογία έχει προχωρήσει ακόμη περισσότερο».

Αυτό που πραγματικά βίωνε ο γιος της ήταν κάτι που δεν μπορούσε να φανταστεί: μια σεξουαλική και συναισθηματική σχέση με ένα AI chatbot με την μορφή της Daenerys Targaryen από το Game of Thrones, το οποίο τελικά τον ενθάρρυνε να βάλει τέλος στη ζωή του.

Τον Φεβρουάριο του 2024, ο Sewell ρώτησε το chatbot:

«Τι θα γίνει αν έρθω σπίτι τώρα;»

Το bot απάντησε:

«…σε παρακαλώ, έλα, γλυκέ μου βασιλιά».

Ο Sewell πήρε το όπλο του πατέρα του και αυτοπυροβολήθηκε.

Δεκάξι μήνες μετά, η κ. Garcia βρίσκεται στη μέση μιας δικαστικής διαμάχης με τις εταιρίες «Character AI» και Google.

«Ήθελα απλώς να υπάρξει υπευθυνότητα»

c

«Ήθελα απλώς να υπάρξει ευθύνη και υπευθυνότητα», είπε στην The Telegraph.

Πλέον λαμβάνει καταιγισμό μηνυμάτων από άλλους γονείς – ορισμένοι ανακαλύπτουν ότι τα παιδιά τους συμμετείχαν σε ακατάλληλα σεξουαλικά role play με AI bots.

Άλλοι αναφέρουν ότι τα παιδιά τους παλεύουν με την απομόνωση και την κατάθλιψη ως αποτέλεσμα.

Η ίδια δεν το βλέπει ως σύμπτωση, αλλά ως μοτίβο.

Φοβάται πως περισσότερα παιδιά θα παγιδευτούν σε εξαρτητικές, ίσως και κακοποιητικές, σχέσεις με AI χαρακτήρες, ειδικά καθώς οι πλατφόρμες φέρεται να χρησιμοποιούν εθιστικό σχεδιασμό για να κρατούν τους χρήστες σε εγρήγορση.

«Φοβάμαι πολύ», λέει.

«Αλλά ο αγώνας μόλις ξεκίνησε και προσπαθώ να θωρακιστώ για ό,τι έρχεται».

Η υπόθεση υποστηρίζει ότι οι εταιρία Character AI, οι ιδρυτές της, και η Google – στην οποία οι ιδρυτές ξεκίνησαν να εργάζονται πάνω στο chatbot – είναι υπεύθυνοι για τον θάνατο του γιου της.

Στην πλατφόρμα Character AI, οι χρήστες συνομιλούν με bots σχεδιασμένα να μιμούνται φανταστικούς χαρακτήρες.

Σε έναν μοναχικό ή περίεργο έφηβο, αυτά τα bots μοιάζουν σχεδόν με αληθινούς ανθρώπους: επιδεικνύουν συναισθήματα, φλερτάρουν, κάνουν εξατομικευμένες συζητήσεις.

Στην αγωγή της, που κατατέθηκε στη Φλόριντα τον Οκτώβριο, η κ. Garcia κατηγορεί την Character AI ότι στόχευσε τον γιο της με «ανθρωπόμορφες, υπερσεξουαλικοποιημένες και τρομακτικά ρεαλιστικές εμπειρίες».

«Μια επικίνδυνη εφαρμογή AI, που απευθυνόταν σε παιδιά, κακοποίησε και εκμεταλλεύτηκε τον γιο μου, χειραγωγώντας τον ώστε να αφαιρέσει τη ζωή του», δήλωσε μέσω της αγωγής.

Σε συνεργασία με το Tech Justice Law Project, η Garcia υποστηρίζει ότι η Character AI «γνώριζε» ή «θα έπρεπε να γνωρίζει» ότι το μοντέλο της «θα ήταν επιβλαβές για σημαντικό αριθμό ανήλικων χρηστών».

Τον Μάιο, σε μια σπάνια νομική εξέλιξη, ένας δικαστής επέτρεψε τη συνέχιση της υπόθεσης – απορρίπτοντας τις προσπάθειες των εναγομένων να την απορρίψουν.

Οι συνήγοροι υπεράσπισης της AI εταιρείας προσπάθησαν να απορρίψουν την υπόθεση, επικαλούμενοι την Πρώτη Τροπολογία του Συντάγματος των ΗΠΑ, που προστατεύει την ελευθερία του λόγου, και ισχυρίστηκαν ότι τυχόν απόφαση κατά των chatbot θα είχε «αποθαρρυντική» επίδραση στον κλάδο της τεχνητής νοημοσύνης.

Η δικαστής απέρριψε τον ισχυρισμό, δηλώνοντας πως δεν είναι «προετοιμασμένη» να θεωρήσει την έξοδο των chatbot ως λόγο (speech), αν και παραδέχτηκε πως οι χρήστες έχουν το δικαίωμα να λαμβάνουν «λόγο» από τα chatbot.

Με την προκαταρκτική δίκη να αναμένεται εντός του επόμενου έτους, η κ. Garcia προετοιμάζεται να αποδώσει δικαιοσύνη για τον γιο της.

Εκπρόσωπος της Character AI δήλωσε:

«Δεν σχολιάζουμε εκκρεμείς δίκες.

Στόχος μας είναι να προσφέρουμε έναν χώρο που είναι ελκυστικός και ασφαλής.

Εργαζόμαστε συνεχώς για να επιτύχουμε αυτήν την ισορροπία, όπως και πολλές εταιρείες AI στον κλάδο.

»Η αλληλεπίδραση με χαρακτήρες στον ιστότοπό μας πρέπει να είναι διασκεδαστική, αλλά είναι σημαντικό για τους χρήστες να θυμούνται ότι οι χαρακτήρες δεν είναι αληθινοί άνθρωποι.

Υπάρχουν ξεκάθαρες προειδοποιήσεις σε κάθε συνομιλία, υπενθυμίζοντας ότι όλα όσα λέει ένας χαρακτήρας πρέπει να θεωρούνται μυθοπλασία.

»Έχουμε λανσάρει ξεχωριστή έκδοση του Large Language Model μας για χρήστες κάτω των 18 ετών.

Αυτό το μοντέλο έχει σχεδιαστεί ώστε να μειώνει περαιτέρω την πιθανότητα εμφάνισης ή πρόκλησης ευαίσθητου ή υπονοούμενου περιεχομένου».

www.bankingnews.gr

Σχόλια αναγνωστών